大数据

代码规范

最短路

ATECLOUD

web前端

决策树

kudu读写流程

Cartographer

Setup 函数的使用

目录和文件管理

绝对路径和相对路径

autocad

代码混淆

知识等级分类

DDD领域驱动设计

族谱

HashTable

比较两个宽字符串的字符

仿抖音APP

毕业论文

模型评估

2024/4/14 18:44:06【Scikit-Learn 中文文档】模型评估: 量化预测的质量 - 模型选择和评估 - 用户指南 | ApacheCN

中文文档: http://sklearn.apachecn.org/cn/stable/modules/model_evaluation.html

英文文档: http://sklearn.apachecn.org/en/stable/modules/model_evaluation.html 官方文档: http://scikit-learn.org/stable/

GitHub: https://github.com/apachecn/scikit-learn-doc-zh&…

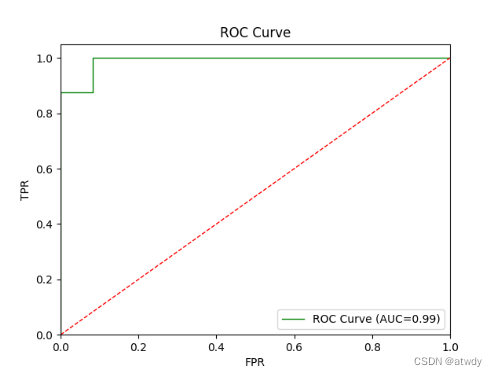

分类模型评估:混淆矩阵与ROC曲线

1.混淆矩阵2.ROC曲线 & AUC指标 理解混淆矩阵和ROC曲线之前,先区分几个概念。对于分类问题,不论是多分类还是二分类,对于某个关注类来说,都可以看成是二分类问题,当前的这个关注类为正类,所有其他非关注…

[机器学习的模型评估很难吗!?]生成ROC,PR,混淆矩阵(给你打包成函数了0.T)

生成ROC,PR,混淆矩阵写在前面ROC曲线生成代码有关汽车评估roc曲线没有梯度的原因PR曲线生成代码同样地,对比在不同叶子纯度的情况的PR图混淆矩阵生成代码想看不同模型之间的Friedman检验吗?写在前面

汽车评估 机器学习 第十四组 “人见人爱,花见花开&a…

【LLM评估篇】Ceval | rouge | MMLU等指标

note

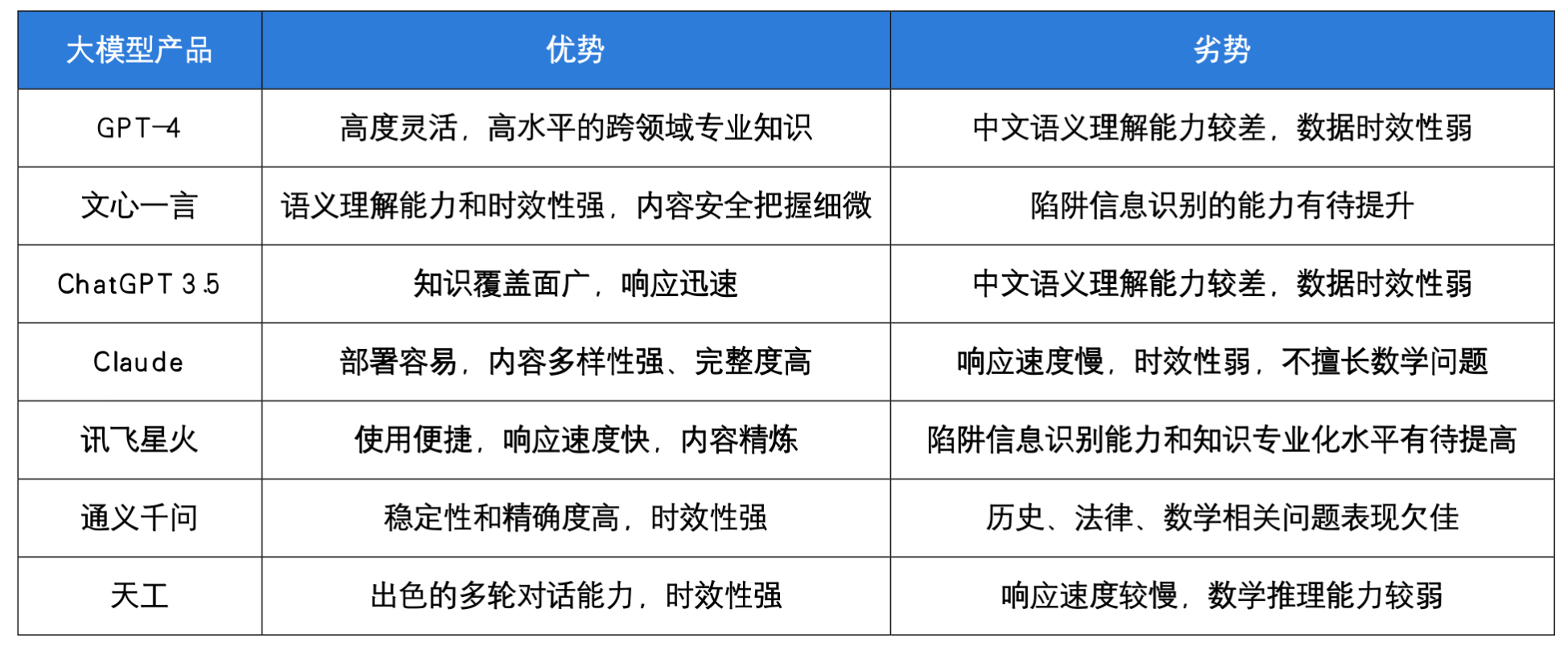

一些大模型的评估模型:多轮:MTBench关注评估:agent bench长文本评估:longbench,longeval工具调用评估:toolbench安全评估:cvalue,safetyprompt等 文章目录 note常见评测benchm…

人工智能中的模型评估

1 概述

1.1 定义

人工智能(AI)模型评估是一个关键的过程,用于确定模型在特定任务上的性能和有效性。这个过程涉及使用各种技术和指标来衡量模型的准确度、可靠性、泛化能力以及其他重要特性。在不同的应用场景中,模型评估的具体…

【机器学习基础】机器学习的模型评估(评估方法及性能度量原理及主要公式)

🚀个人主页:为梦而生~ 关注我一起学习吧! 💡专栏:机器学习 欢迎订阅!后面的内容会越来越有意思~ 💡往期推荐: 【机器学习基础】机器学习入门(1) 【机器学习基…

2.6 如何计算AUC?

2.6 如何计算AUC? 前情提要: 2.4 ROC曲线是什么? 2.5 如何绘制ROC曲线? AUC定义:AUC指的是ROC 曲线下的面积大小,该值能够量化地反映基于ROC曲线衡量出的模型性能。

计算方法:计算AUC值只需要…

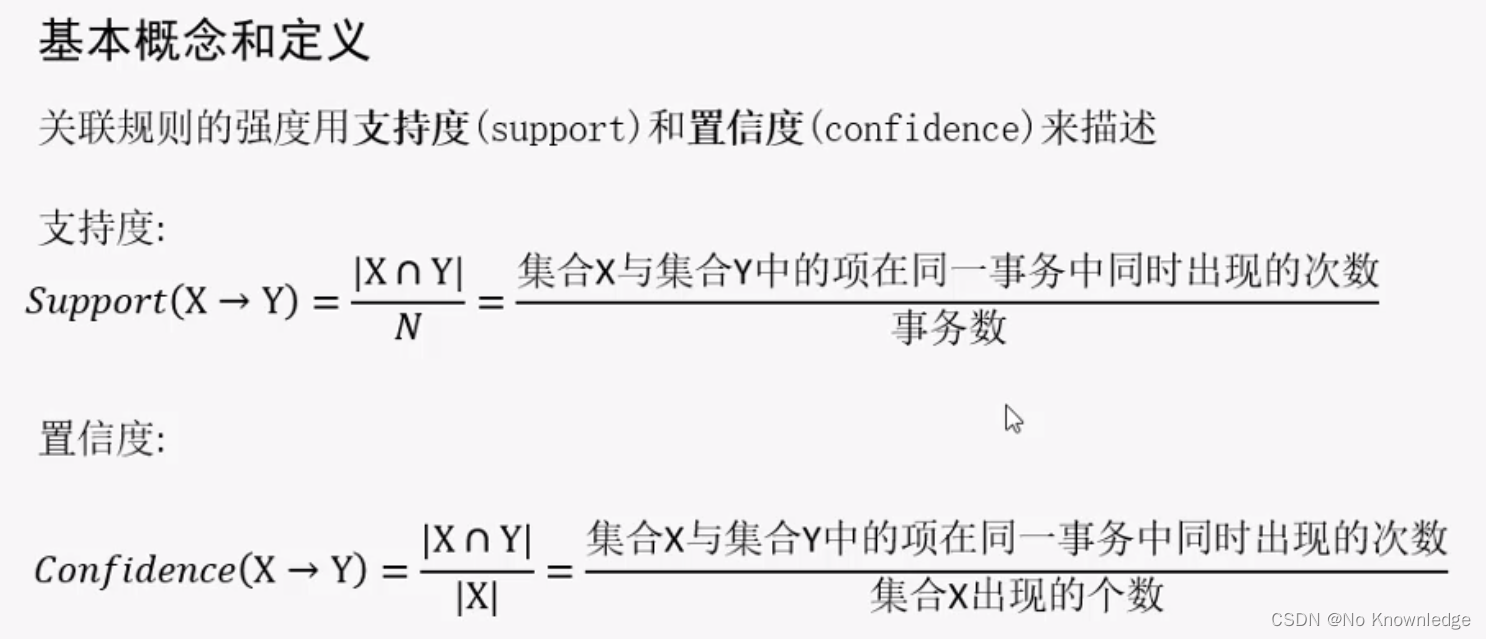

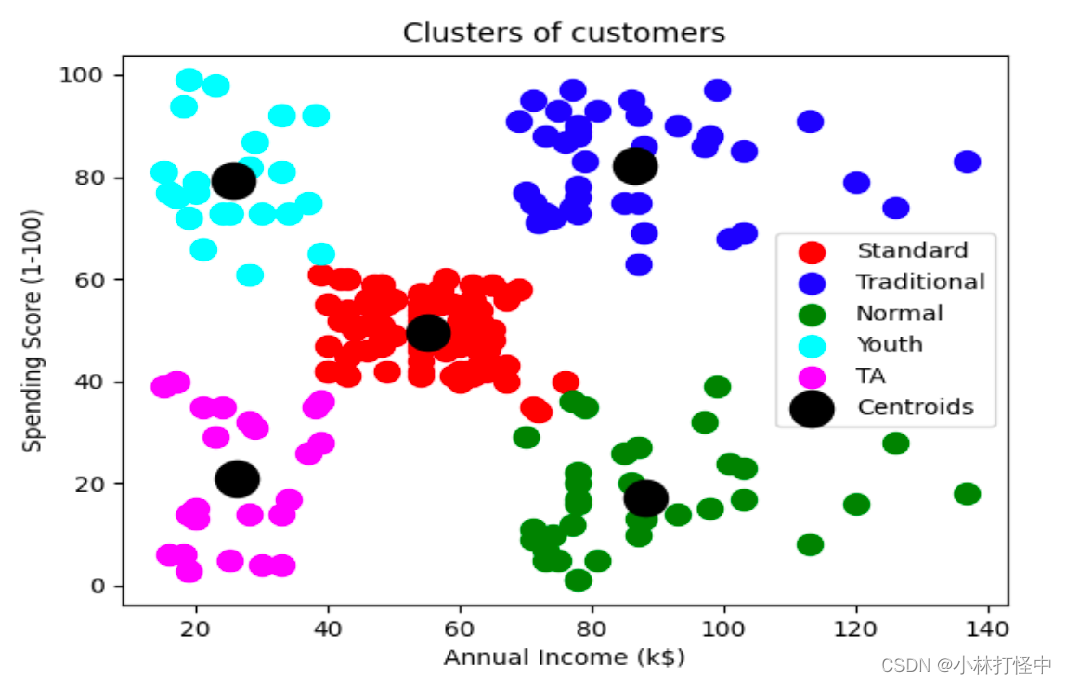

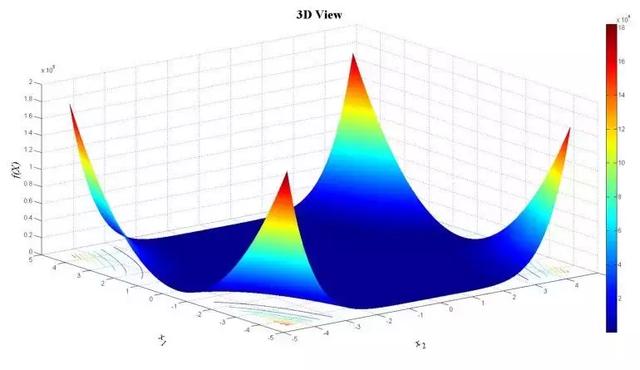

聚类算法(KMeans)模型评估方法(SSE、SC)及案例

一、概述 将相似的样本自动归到一个类别中,不同的相似度计算方法,会得到不同的聚类结果,常用欧式距离法;聚类算法的目的是在没有先验知识的情况下,自动发现数据集中的内在结构和模式。是无监督学习算法

二、分类

根据…

机器学习(二):模型评估与模型选择、正则化与交叉验证、L0,L1,L2正则化、泛化能力

训练误差与测试误差

机器学习的目的是使学习到的模型不仅对已知数据而且对未知数据都能有很好的预测能力。不同的学习方法会给出不同的模型。当损失函数给定时, 基于损失函数的模型的训练误差(training error) 和模型的测试误差(…

探索人工智能 | 模型训练 使用算法和数据对机器学习模型进行参数调整和优化

前言

模型训练是指使用算法和数据对机器学习模型进行参数调整和优化的过程。模型训练一般包含以下步骤:数据收集、数据预处理、模型选择、模型训练、模型评估、超参数调优、模型部署、持续优化。 文章目录 前言数据收集数据预处理模型选择模型训练模型评估超参数调…

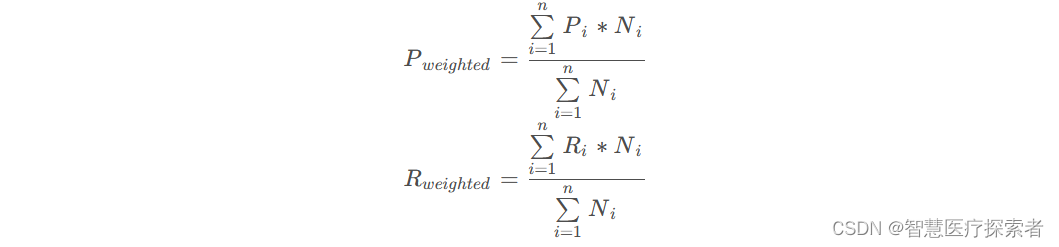

模型评估函数的优缺点、选择举例

参考书籍《百面机器学习》

1.评估指标的局限性

涉及到的评估指标(Accuracy,precision,recall,rmse) (1)准确率的局限性 局限性:对于样本类别之间数量差距很大的数据,运…

![[机器学习的模型评估很难吗!?]生成ROC,PR,混淆矩阵(给你打包成函数了0.T)](https://img-blog.csdnimg.cn/20210518182351387.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3FxXzQyMTM2ODMy,size_16,color_FFFFFF,t_70)